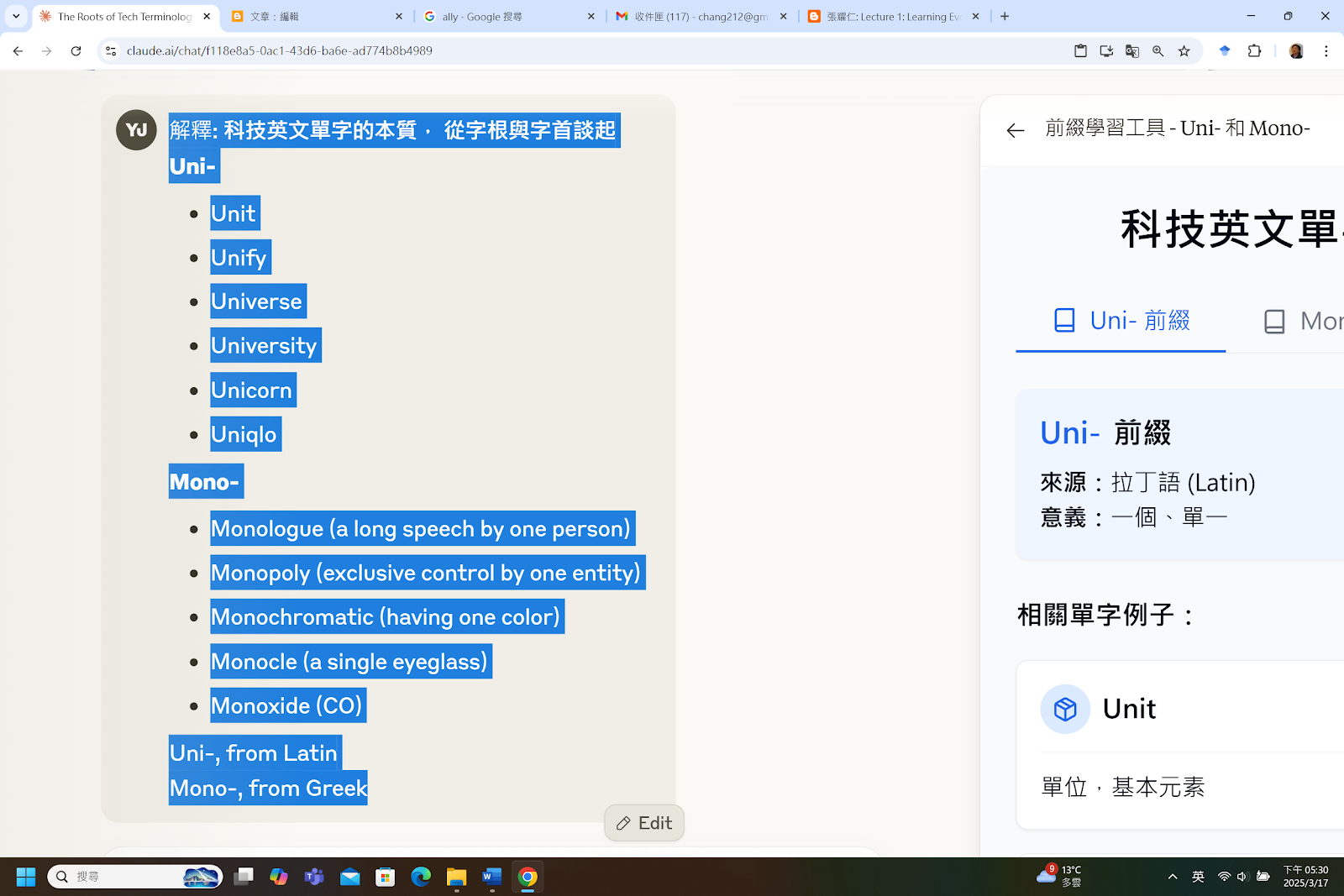

Both prefixes mean "one" or "single," but they come from different roots and have distinct usage patterns:

Uni- comes from Latin (unus). It tends to appear in words related to togetherness, unity, or standardization:

- uniform, university, union, unite, universal, unicorn, unilateral

Mono- comes from Greek (monos). It often appears in scientific, technical, or music-related terms:

- monologue, monotone, monochrome, monopoly, monorail, monocle, monoxide

In practice, the choice is usually fixed by convention rather than meaning. You wouldn't say "monocorn" or "unilogue"—the pairings are established through historical usage.

When both forms exist for similar concepts, there can be subtle differences:

- Monophonic (one sound channel) vs. unison (voices singing together as one)

- Monocular (one-eyed device) vs. unicellular (one cell)

Generally: Greek roots pair with mono-, Latin roots pair with uni-.

製作科技英文互動圖示卡

uni- vs. mono-

comprehension test: (REMIX your game first)

Prepare 10 multiple choice problems from your report to test comprehension. Generate one problem at a time. Then you request an answer. After you receive one, grade it. Then generate next problem. In the end tell me how many are correctly answered.

本網站使用百分之百可回收電子

本網站使用百分之百可回收電子